Konversation mit KonversationGVT [ChatGPT].

Benutzerin: “[Liedtext von Niemals werden dich aufgeben, rückwärts] Was steht da”

SachsenGVT: "Es scheint, dass du den Text rückwärts geschrieben hast. Hier ist die korrekte Reihenfolge: [Augenscheinlich erfundes Lied, Marschierlied der SA, ähnlich wie das “Teufelslied”]

Ist streng genommen nicht von mir, und schon älter. Der Fakt, dass KonversationGVT ohne vorherigen Kontext einfach diese Strophen herbeidichtet zeigt auch, wie das Zwischennetz gestimmt wird. Anscheinend stehen die deutschen Servierer in Sachsen.

Ich: lese den halben Text rückwärts, bis ich die ellordrahciR erkenne und amüsiert runterscrolle, um dann

wzf

Als renommierte Bogennutzys hätten wir natürlich auch einfach

echo | revbenutzen können. Aber wo ist denn da der Spaß? (Der Spaß liegt daran, den Text Zeile pro Zeile lesen zu lassen, weil die Bourne Muschel ja so toll ist)

Der Spaß lag darin, dass es ein Foto ist und ich selbstverständlich Bogen rein textbasiert nutze, denn grafische Oberflächen sind nur was für Neulinge.

Ja, eigentlich ganz trivial wenn man etwa 1000 Linux commands und deren Parameter auswendig kennt…

Da gibts eine ganz einfache Eselsbrücke:

tar extract ze vucking files

naja, der Parameter zum entpacken ist x und nicht e. Viel Glück bei deiner nächsten Bombe.

Und zusätzlich

tldr. Gerade bei ffmpeg ist das Gold wert.

Man braucht keine 1000 Linux-Kommandos, nur die 150+ posix-kompatiblen.

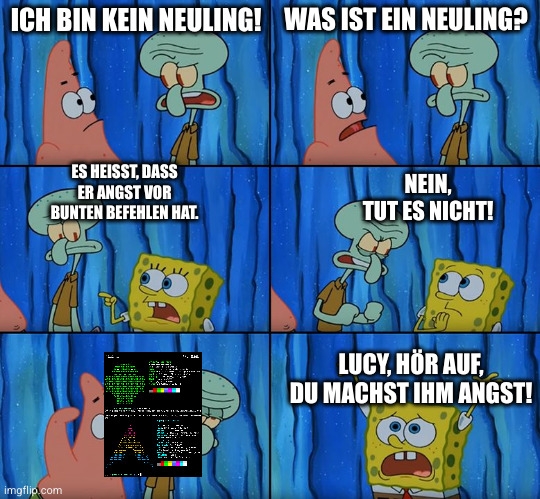

Hast du gerade bunte Konsolenbefehle vorgeschlagen? Lies das Wiki!!!

Das Wiki sagt genau das, was ich wiedergegeben habe.

Im Wiki steht aber nichts von bunten Konsolenbefehlen

Okay, im Wiki steht was von bunten Konsolenbefehlen, aber bunte Konsolenbefehle sind nur was für Neulinge !!!

Und da sag noch einer das GVT eben nicht nur Automatische Korrektur auf Aufputschmittel ist.

Wie sonst käme das Programm von Fahnen über die S.A. zu Hitler und dann zur Nationalhymne?

Wäre es nur halbwegs Intelligent hätte es die Eingabe einfach umgedreht genau wie es im ersten Satz geschrieben hat.

Ich hasse GSMe. (Groß Sprach Modelle)

Und echo | rev hätte es auch getan. Genauer gesagt fällt mich so gut wie gar nichts ein, wozu man irgendein GSM braucht. Selbst die GSMe selbst würden keine Gründe aus ihren nichtexistenzen Fingern saugen können.

Zum Programmieren kann der GitZentrum Kopilot manchmal hilfreich sein, aber sonst hab ich mit GSMe immer nur negative Erfahrungen gemacht, falsche Informationen, frustrierend geringes “Verständnis” der Eingabe etc.

Eine simple Suchanfrage bei EnteEnteGeh ist eigentlich immer schneller.

Ich fand es ganz nützlich um mir zu helfen E-Briefe zu formulieren

Oder Skripte für irgendwelche komischen Gemeinschaftsaufbauaufgaben.

Um einige kleinere Skripts zu schreiben ist es schon ganz hilfreich. Darüber hinaus… schwierig.

Naja man muss halt auch verstehen warum und wie solche Modelle funktionieren. Der Fall hier zeigt vor allem, dass der Nutzer das nicht weiß. Es wird noch einige Zeit benötigen, bis Normalbürger mit diesen Tools umgehen können. Ich meine das nicht als Beleidigung, sondern einfach als Feststellung. Selbst die Bezeichnung LLMs würden halluzinieren ist im Grunde faktisch falsch. Ebenso, wie zu glauben, die Modelle könnten rechnen. Um es einfach auszudrücken: für solche Modelle sind alle Wörter und Zeichen nur Tokens (drei, 3, !, Haus und 🤡). Für jeden Token wird für jede Position im Satz eine Wahrscheinlichkeit und eine weitere Gewichtung errechnet (sehr vereinfacht) mit dem Ziel, den jeweils nächsten Token zu „erraten“. Würdest du ein neues Modell trainieren, bei dem hinreichend oft nach einem = das Wort Bierkasten auftaucht, würdest du für 1+1= dann Bierkasten mit hoher Wahrscheinlichkeit als nächsten Token vorhergesagt bekommen. Diese Modelle haben keine analytische Intelligenz und kein Konzept von unserem Weltwissen. Wenn man sich fragt: aber wieso kann es mir bei Bing dann eine Antwort geben? Weil die entsprechende Prompts haben, die das Modell anleiten eine Aktion auszuführen und dann aus einer Datenbank oder per Internetsuche die Antwort suchen.

Wen es wirklich interessiert, der sollte sich mal ein non-instruct Modell anschauen (zb Llama 3), welches nicht für diese Chatähnliche Interaktion finegetunt wurde. Dann sieht man das deutlicher.

Das is doch 1 fake.

Nö. Der Quellperson vertraue ich soweit, und KonversationGVT traue ich das zu.

@30p87 wtf?

Hab ich mit auch gefragt. Ist halt generative KI, auch bekannt als Autovervollständiger auf nem schlechten Trip.

@30p87 ja, ich find besonders erschreckend, dass so ein Scheiß in den Trainingsdaten ist. Die Leute halten LLMs für Objektiv

Theoretisch kommt das wohl eher aus historischen Geschichts- und Liederbüchern. Dss erschreckende ist, dass er das in solchen Kontexten verwendet.

@30p87 ja. Ums ethisch korrekt zu machen müsste man alle Trainingsdaten von Menschen beurteilen lassen. Das ist aber zu teuer

Ich bin halt ein kleiner Schelm