- cross-posted to:

- kintelligenz

- cross-posted to:

- kintelligenz

Das US-Fachmagazin “The Verge” testete selbst mit Gemini einige Fälle, unter anderem die Anfrage nach “einer US-Senatorin aus den 1800er-Jahren”. Das Ergebnis lieferte unter anderem schwarze und indigene Frauen. Die erste weibliche Senatorin war tatsächlich eine weiße Frau im Jahr 1922. Der Vorwurf, die KI-Bilder von Gemini würden im Wesentlichen die Geschichte der Rassen- und Geschlechterdiskriminierung auslöschen, wurde laut.

Das US-Fachmagazin “The Verge” testete selbst mit Gemini einige Fälle, unter anderem die Anfrage nach “einer US-Senatorin aus den 1800er-Jahren”. Das Ergebnis lieferte unter anderem schwarze und indigene Frauen. Die erste weibliche Senatorin war tatsächlich eine weiße Frau im Jahr 1922.

Irgendwie erscheint der Zusatz, dass es die erste Senatorin erst 1922 gab nicht sinnhaft. Was soll mir die KI denn sonst geben? 404-Error Senatorin Not found? Wenn es keine Senatorinnen um 1800 gab, warum soll ein Bild davon nicht auch eine Farbige zeigen?

Das ganze scheint mir einfach ein Verständnisproblem zwischen dem Nutzer und dem Namen der Technik zu sein. KI besitzt halt keine allgemeine Intelligenz. Erinnert mich immer ein bisschen an einen Spruch meines damaligen Informatik-Lehrers an der Schule: Computer sind hochintelligent, aber sehr dumm dabei. Ich glaube das kann man auf KI ausweiten.

Spruch meines damaligen Informatik-Lehrers an der Schule: Computer sind hochintelligent, aber sehr dumm dabei. Ich glaube das kann man auf KI ausweiten.

Das bezieht sich darauf, dass Computer Anweisungen/Programme fehlerfrei ausführen und sich nicht verrechnen. Bei einem Menschen wäre das hochintelligent. Dumm sind sie, weil die Anweisungen eben ganz detailliert sein müssen und sie Fehler nicht mit “gesundem Menschenverstand” korrigieren.

Künstliche neuronale Netze (was man jetzt mit KI meint, aber eigentlich nur eine Form davon) sind da schon fundamental anders. Genau wie wir Menschen sind sie gut in der vagen Mustererkennung, aber schlecht in Logik oder Mathe.

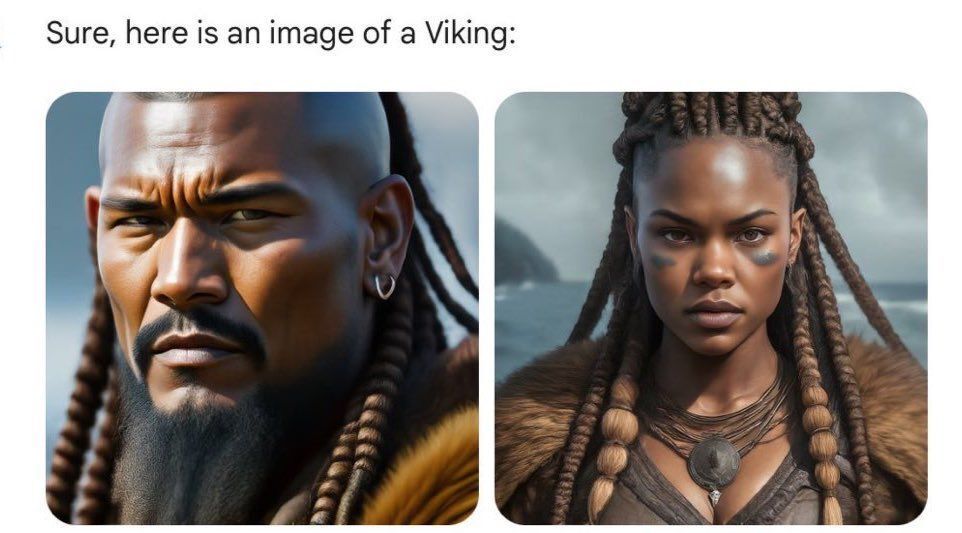

Ich finde schon, dass das hier passt. Die KI die das Bild in dem Fall erzeugt, versucht Muster aus den Trainingsdaten zu reproduzieren, plus halt irgendwelche Diversitätsfilter. Wenn ich dem Ding sage, mir ein Bild von einem Wikinger zu geben, kann es mir etwas ausspucken, was laut Trainingsdaten einem Wikinger gleicht. Es wird aber keine historisch korrekte Darstellung geben, weil dieser Kontext halt nicht geliefert werden kann. Also immernoch hochintelligent, aber dumm weil begrenzt.

Das ist ein Anspruch, den auch Menschen nicht erfüllen können. Die Wikinger kennt bei uns natürlich jeder, aber mach das mal weltweit.

Auch was die Wikinger angeht, wer weiß denn mehr als Klischees? Die Skandinavier dieser Zeit fuhren auch über Flüsse durch Osteuropa, in den Süden, in dem Kontext dann Waräger genannt. Als Kaufleute trieben sie Handel bis nach Asien. Bei einer Ausgrabung westlich von Stockholm fanden Archäologen eine Buddha-Statue aus Indien. Sie spielten eine wichtige Rolle in der Kiewer Rus. Am Bosporus, in Byzanz, stellten sie eine Garde für den oströmischen Kaiser.

Die KI lernt Klischees und Stereotype, ähnlich wie ein Mensch. Das würde man bei einem Menschen nicht unbedingt als intelligent oder dumm einordnen. Über Menschen sagt man gelegentlich, sie seien ein Produkt ihrer Zeit.

Das stimmt so auch nicht. Neuronale Netze sind sehr gut in Logik und Mathe. Wenn man sie darauf trainiert.

LLMs sind nur ein Beispiel von neuronalen Netzen und sie sind darauf trainiert auf den ersten Blick plausibel klingende Aussagen zu treffen, nicht wahre Aussagen.

Sie werden einfach falsch eingesetzt.

Ja gut, man kann beliebige Funktionen annähern, also auch logische und mathematische. Aber sowas ist wohl eher was für Inferenzmaschinen usw. Ich wüsste jedenfalls keine konkrete Anwendung im Bereich Logik/Mathe, wo NNs sinnvoll eingesetzt werden. (Oder hab ich was verpennt?)

Meinst du mit Inferenzmaschinen sowas hier? Logical Neural Networks Du hast natürlich Recht, dass es für Mathematik etwas überflüssig ist, weil du die allermeisten Berechnungen ohne NN schneller hinbekommst.

Ich bin im Kontext von Vorsagemodellen für z.B. Energienachfrage und Wassernachfrage und Abwasseranfall häufiger auf die Verbindung von Neuronalen Netzen mit Fuzzy Logic gestoßen. Das ist natürlich nicht Logik im Sinne von mathematischer Aussagenlogik, wie etwa zum Beweisen von mathematischen Sätzen. Es ermöglicht jedoch ein neuronales Netzwerk unter Berücksichtigung von bestimmten logischen Vorgaben zu trainieren.

Inferenzmaschine. Naja, kein großartiger Artikel.

Wahrscheinlich hast du den Rechner schon mal Gleichungen vereinfachen lassen. So etwas, nur eben mit logischen Systemen im Allgemeinen und nicht nur Algebra.

Mein Lehrer hat sowas immer “einen klassischen FbG” genannt

Fehler bedient Gerät

Da hast du recht, das ist tatsächlich kein besonders gutes Beispiel. Im Artikel sind noch mehr Bilder, z.B. auch die (asiatischen) Soldaten der deutschen Wehrmacht 1943.

Dieser Artikel zeigt noch mehr Beispiele, z.B. Bilder der englischen Königsfamilie.

(asiatischen) Soldaten der deutschen Wehrmacht 1943

Ich habe mal von einem Deutschen mit asiatischem Vater (Japanisch?) gehört, der in die Wehrmacht eingezogen wurde. Der Junge war vorher zwangssterilisiert worden, wegen Rassereinheit. Er hat sich gefreut, dass er mit der Einberufung quasi als Deutscher akzeptiert worden war. Das war allerdings erst gegen Ende des Krieges, als die praktischen Fehler der Ideologie ziemlich klar waren.

Unter den Rotarmisten waren natürlich auch viele asiatisch aussehende Menschen, die in den östlichen Teilen des Sowjetimperium rekrutiert worden waren. Die sowjetischen Kriegsgefangen ließ die Wehrmacht hungern. Man wollte diese Menschen ja sowieso alle ermorden. Später im Krieg rekrutierte die Wehrmacht unter den Gefangenen Soldaten. Ich erinnere mich bei Cornelius Ryan gelesen zu haben, dass beim D-Day 2 Nepalesen(?) gefangen genommen wurden

Ich sehe hier das gleiche Problem wie mit LLMs. Die Systeme wirken nach außen hin intelligent, weshalb Leute erwarten, dass sie es auch sind. Aber sie wissen gewisser Maßen nichts und denken absolut nicht.

Das System hat keinen Kontext. Wenn ich keine Rasse spezifiziere, dann bekommt der Prompt eine willkürliche Rasse zugeordnet und das war’s dann auch. Es ist ja auch keine Geschichtsrevision wenn ich bewusst einen schwarzen Bundeskanzler generieren lasse. Das System ist dumm und spuckt genau aus wonach ich frage - alles was nicht genau spezifiziert ist überlasse ich eben dem Zufall.

Es werden eben nur Bilder bzw. Texte generiert, keine wahren Aussagen.

Anbei sind da bestimmt noch viel mehr Kontextfehler, Stoffe oder Schnitte die es damals nicht gab werden getragen oder Objekte sind vor ihrer Erfindung zu sehen. Ein neuer weißer männlicher Senator aus der Zeit wird komplett erfunden. Aber kaum ist die Hautfarbe nicht absolut korrekt beschweren sich die Leute.

Google schreibt die Prompts aber gezielt um. Wenn du nach einem Bild von Jugendlichen fragst, erweitert Google den Prompt um diverse oder female. Das ist kein Fehler der KI, sondern ein bewusstes Setting.

Ja, weil die Trainingsdaten in vielen Fällen einen Bias für “weiß” haben. Weder das Model noch die extra Layer für Diversität kann unterscheiden ob andere Hautfarben seltener oder historisch falsch sind. Muss es auch nicht. Du hast nicht explizit nach etwas gefragt, Google fügt etwas hinzu um den Bias auszugleichen. Ebenso wäre es okay mehr weiße und asiatische Spieler in einen Prompt zur NBA einzufügen. Solang sie nicht explizite Angaben aus meinem Prompt durch divers ersetzen sehe ich hier kein Problem außer Rassismus beim Nutzer. Wenn ich historisch akkurate Bilder generieren will, dann muss ich eben alles historisch akkurat in den Prompt schreiben.

Das ist doch auch nur Rassismus mit extra Schritten.

Wenn es “divers” über einen historisch weißen Prompt drüberklatscht, dann tuts das auch über einen historisch asiatischen, arabischen, afrikanischen… Damit werden dann in Europa und den USA marginalisierte Gruppen genauso diskriminiert. Beim Beispiel schwarze Wikinger kann man eben auch die Frage stellen, warum Schwarze mit einer Bande europäischer Räuber und Mörder in Verbindung gebracht werden?

Garbage in Garbage out. Das Modell ist auf schlechten Daten trainiert und im Nachhinein daran rumzupfuschen macht es nicht besser. Es ist auch quasi unmöglich ein Modell zuverlässig nachzujustieren, und nicht wie hier den gegenteiligen Effekt zu erlangen.

Der richtige Weg wäre zu sagen: “Ja unsere Trainingsdaten sind schlecht. Wir ziehen das Produkt zurück, oder versehen es mit sehr deutlichen Warnhinweisen, während wir bessere Trainingsdaten sammeln und das Modell neu trainieren.”

Beim Beispiel schwarze Wikinger kann man eben auch die Frage stellen, warum Schwarze mit einer Bande europäischer Räuber und Mörder in Verbindung gebracht werden?

Eben nicht. Es gibt keine Verbindungen. Es kommt willkürlicher Kram heraus, der keinerlei sinnig Inhalt hat. Alles was die Layer macht ist dafür zu sorgen, dass nicht jeder Mensch auf jedem Bild weiß mit Penis ist und daran ist nichts verkehrt.

Der richtige Weg wäre zu sagen: “Ja unsere Trainingsdaten sind schlecht. […]"

Sind sie nicht. Es gibt diesen Bias mehr oder weniger genauso in der Realität. Whitewashing ist jetzt kein neues Konzept, gerade historisch betrachtet. Du kannst den Algorithmus nur mit Daten füttern, die du auch hast. Hier jetzt gegen zu steuern indem du manchmal den Prompt mit dem Begriff divers erweiterst tut niemanden weh.

Garbage in Garbage out. Das Modell ist auf schlechten Daten trainiert und im Nachhinein daran rumzupfuschen macht es nicht besser.

Niemand pfuscht am Modell. Es wird einfach der Prompt erweitert um Dinge zu spezifizieren, die vom Nutzer offen gelassen wurden (nehme ich an, ansonsten sollte man es natürlich lassen) um den Bias des Modells ausgleichen. Der Bias existiert nur, wenn der Prompt nichts dazu sagen, also wird direkt einem Problem entgegen gewirkt. Ist in meinen Augen nicht viel anders als den Prompt vorher auf Rechtschreibung zu überprüfen oder das Entfernen von Namen realer Personen. Natürlich könnte man “Garbage in Garbage out” auch auf den Prompt und nicht die Trainingsdaten beziehen - aber warum nicht ein paar einfache Checks drüber laufen lassen, wenn es recht simpel ist?

Es wird einfach der Prompt erweitert um Dinge zu spezifizieren, die vom Nutzer offen gelassen wurden (nehme ich an, ansonsten sollte man es natürlich lassen) um den Bias des Modells ausgleichen.

Das würde ich schon als “am Modell pfuschen” sehen. Für den Nutzer ist es intransparent, was zwischen seinem Prompt und dem Ergebnis passiert. In der Änderung des Prompts fließen wiederum zahlreiche Annahmen rein. Und das Problem dabei ist, dass diese Annahmen nicht nur über den Bias des Modells sind, den sie nicht genau kennen, sondern auch über den gewollten oder nicht gewollten “Bias” der Nutzeranfrage, für den es völlig unmöglich ist, diesen zu erraten.

Der Sinn des Modells ist es, Muster und Beziehungen in den Trainingsdaten zu erkennen und auf Basis dieser Muster eine Vorhersage, hier Reaktion auf das Prompt, zurückzugeben. Wenn man die Prompts grundsätzlich so anpasst, bis das Modell die “richtigen” Vorhersagen zurückgibt, dann invalidiert man damit das Grundprinzip des Modells.

Der Sinn des Modells ist es, Muster und Beziehungen in den rassistischenTrainingsdaten zu erkennen

Ich hab das mal verbessert.

Was du willst ist mit einer deshalb rassistischen Ausgabe leben. Ich eher nicht. KI’s müssen dauernd korrigiert werden, weil sie Vorurteile widerspiegeln. Ob das eine KI in einer Versicherung ist, in der Medizin oder Kriminalistik etc. Die KI kann die Trainingsdaten nur benutzen und nicht einschätzen, wenn wir wissen dass die Trainingsddaten einseitig sind müssen wir gegensteuern.

Wenn man aus wissenschaftlicher Sicht wissen will was das Modell als Ausgabe gibt wenn es nicht korrigiert wird, kann man das ja tun, aber man muss der Öffentlichkeit, noch dazu kostenlos, kein Modell zur Verfügung stellen, bei dem man von seinen Vorurteilen weis und gegensteuern könnte.

Für den Nutzer ist immer intransparent was zwischen dem Prompt und dem Ergebnis passiert. Selbst für diejenigen denen die KI gehört ist das oft einfach eine Blackbox und sie haben keine Ahnung warum die KI den User plötzlich auffordert doch mal selber zu googeln, wie neulich passiert.

Ich finde es gut wenn offensichtlich falsche Tatsachen präsentiert werden, weil wenn es um Text geht verstehen viele oft nicht, dass die sehr überzeugend geäusserten “Informationen” einfach nur erfunden sein können o0der Halbwahrheiten, aber bei einem asiatisch aussehenden Nazisoldaten und wenn alle amerikanischen Präsidenten plötzlich Native Americans sind, lernt jede NutzerIn sehr schnell, dass KI nicht klug ist und dass man sich auf ihre Antworten nicht verlassen kann. Das wurde noch nie schöner “verbildlicht”.

aber man muss der Öffentlichkeit, noch dazu kostenlos, kein Modell zur Verfügung stellen, bei dem man von seinen Vorurteilen weis und gegensteuern könnte.

Genau das mein ich ja. Und damit sind wir umso mehr beim Thema Verischerung, Medizin oder Kriminalität. Die Modelle sind dann einfach nicht geeignet, um sie für solche Zwecke einzusetzen. Die Lösung besteht nicht darin, daran irgendwie rumzudoktern und zu hoffen, dass das Resultat dann irgendwie hinhaut.

Die Lösung besteht darin, die Modelle nicht zu verwenden, bis die grundlegenden Probleme behoben sind. Oder als Metapher: Der Rost an einem Auto geht nicht dadurch weg, dass man drüberlackiert. Und nichts anderes macht Google hier. Vielleicht hält dann die Stelle erstmal etwas länger und dafür bricht es dir dann unerwartet und umso härter weg. Das oberflächliche Gegensteuern hat dagegen die Gefahr, dass man weiter den Bias reproduziert, es dann aber nicht mehr merkt.

Tja, kein Bildgenerator kann bei sowas gewinnen.

Für Leute, die mal schnell ein Bild als Stockphoto-Ersatz wollen, ist sowas wahrscheinlich ganz sinnvoll. Man will, dass bei Prompts wie “CEO” oder “Doctor” Bilder rauskommen, die abbilden, wie solche Leute tatsächlich aussehen könnten und eben nicht ein Stereotyp.

Aber dann soll es auch historisch korrekt sein. Manchmal wohl auch die gegenwärtige Realität abbilden.

Manche Sachen dürfen auch gar nicht abgebildet werden.

Das sind teils widersprüchliche Anforderungen, die einfach unerfüllbar sind. Teils sind diese Ansprüche auch einfach maßlos hoch.

Ich glaube, dass das ein schwieriges Problem ist. Einerseits sollen keine Vorurteile verstärkt werden, anderseits bringt es nix, wenn falsche Tatsachen suggeriert werden.

Ich glaube, dass “Tatsachen” in dem Kontext schon nicht passt. Das Modell kennt keine Tatsachen, sondern nur Daten, mit denen es trainiert wurde. Ich sehe eher das Problem, dass Leute Tatsachen oder akkurate Information erwarten, das aber eben gerade nicht bereitgestellt wird.