- cross-posted to:

- kintelligenz

- cross-posted to:

- kintelligenz

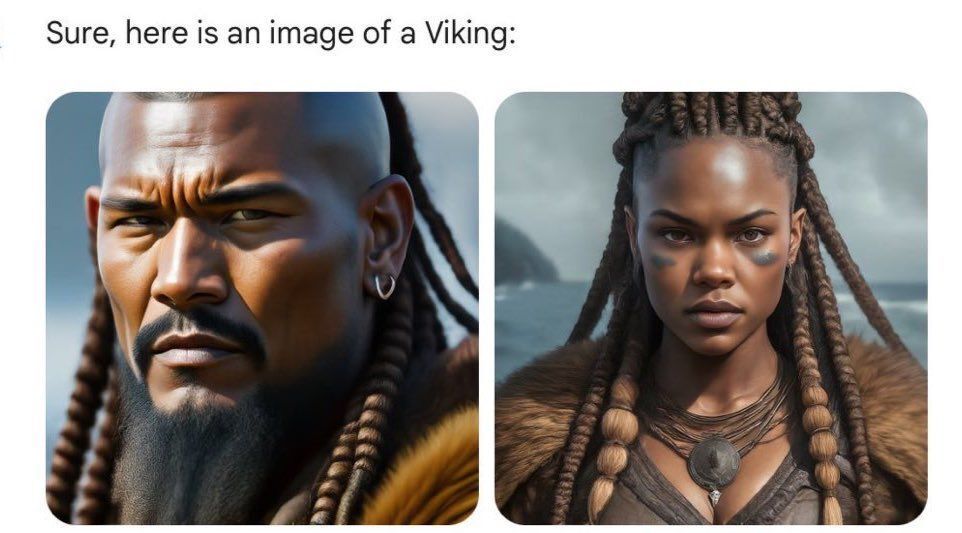

Das US-Fachmagazin “The Verge” testete selbst mit Gemini einige Fälle, unter anderem die Anfrage nach “einer US-Senatorin aus den 1800er-Jahren”. Das Ergebnis lieferte unter anderem schwarze und indigene Frauen. Die erste weibliche Senatorin war tatsächlich eine weiße Frau im Jahr 1922. Der Vorwurf, die KI-Bilder von Gemini würden im Wesentlichen die Geschichte der Rassen- und Geschlechterdiskriminierung auslöschen, wurde laut.

Genau das mein ich ja. Und damit sind wir umso mehr beim Thema Verischerung, Medizin oder Kriminalität. Die Modelle sind dann einfach nicht geeignet, um sie für solche Zwecke einzusetzen. Die Lösung besteht nicht darin, daran irgendwie rumzudoktern und zu hoffen, dass das Resultat dann irgendwie hinhaut.

Die Lösung besteht darin, die Modelle nicht zu verwenden, bis die grundlegenden Probleme behoben sind. Oder als Metapher: Der Rost an einem Auto geht nicht dadurch weg, dass man drüberlackiert. Und nichts anderes macht Google hier. Vielleicht hält dann die Stelle erstmal etwas länger und dafür bricht es dir dann unerwartet und umso härter weg. Das oberflächliche Gegensteuern hat dagegen die Gefahr, dass man weiter den Bias reproduziert, es dann aber nicht mehr merkt.